任何非零都会recurrent_dropout产生 NaN 损失和权重;后者是 0 或 NaN。发生在堆叠的、浅的、stateful, return_sequences= 任何、带有 & w/o Bidirectional()、activation='relu', 的情况下loss='binary_crossentropy'。NaN 出现在几批中。

有什么修复吗?帮助表示赞赏。

已尝试故障排除:

recurrent_dropout=0.2,0.1,0.01,1e-6kernel_constraint=maxnorm(0.5,axis=0)recurrent_constraint=maxnorm(0.5,axis=0)clipnorm=50(凭经验确定),那达慕优化器activation='tanh'- 无 NaN,重量稳定,最多可测试 10 个批次lr=2e-6,2e-5- 无 NaN,重量稳定,最多可测试 10 个批次lr=5e-5- 没有 NaN,权重稳定,3 批次 - 第 4 批次的 NaNbatch_shape=(32,48,16)- 2批次的大损失,第3批次的NaN

注意: ,每批batch_shape=(32,672,16)17 次调用train_on_batch

环境:

- Keras 2.2.4(TensorFlow 后端)、Python 3.7、Spyder 3.3.7(通过 Anaconda)

- GTX 1070 6GB,i7-7700HQ,12GB RAM,Win-10.0.17134 x64

- CuDNN 10+,最新的 Nvidia 驱动器

附加信息:

模型发散是自发的,即使使用固定种子(Numpy、Random 和 TensorFlow 随机种子)也会发生在不同的训练更新中。此外,当第一次发散时,LSTM 层的权重都是正常的——只是稍后才变为 NaN。

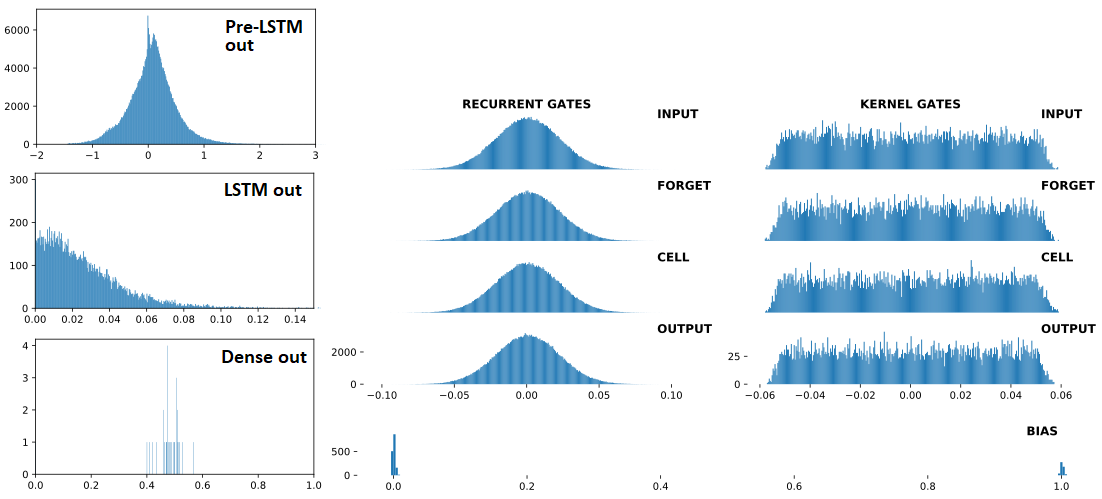

以下是,按顺序:(1)输入LSTM;(2)LSTM输出;(3)Dense(1,'sigmoid')输出——三个是连续的,Dropout(0.5)在每个之间。前面的(1)是Conv1D层。右:LSTM 权重。“之前” = 1 次火车更新之前;"AFTER = 1 次列车更新后

分歧前:

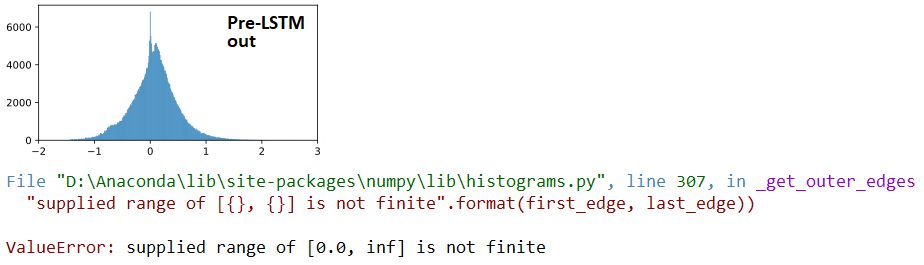

AT 分歧:

## LSTM outputs, flattened, stats

(mean,std) = (inf,nan)

(min,max) = (0.00e+00,inf)

(abs_min,abs_max) = (0.00e+00,inf)

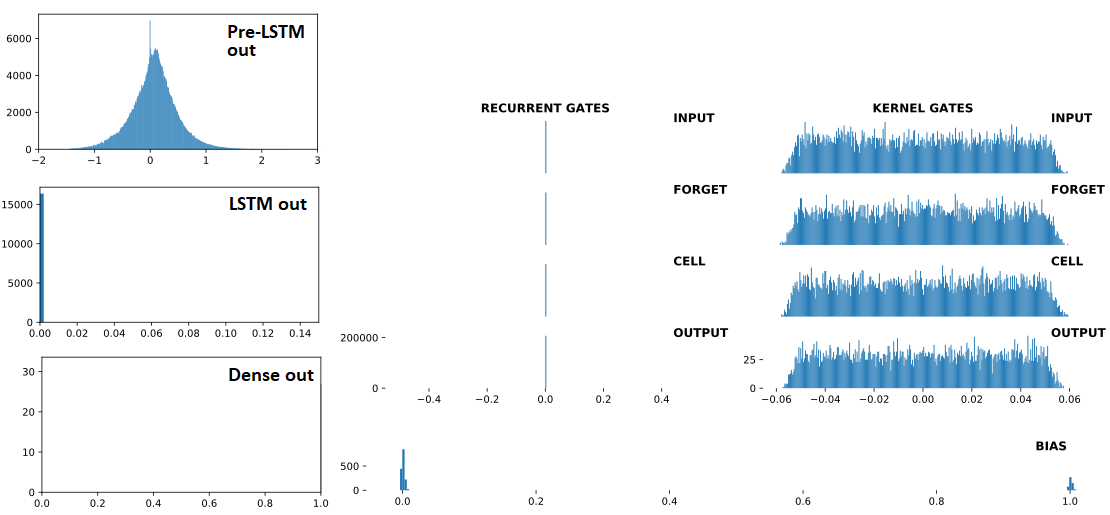

分歧后:

## Recurrent Gates Weights:

array([[nan, nan, nan, ..., nan, nan, nan],

[ 0., 0., -0., ..., -0., 0., 0.],

[ 0., -0., -0., ..., -0., 0., 0.],

...,

[nan, nan, nan, ..., nan, nan, nan],

[ 0., 0., -0., ..., -0., 0., -0.],

[ 0., 0., -0., ..., -0., 0., 0.]], dtype=float32)

## Dense Sigmoid Outputs:

array([[1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.]], dtype=float32)

最小的可重复示例:

from keras.layers import Input,Dense,LSTM,Dropout

from keras.models import Model

from keras.optimizers import Nadam

from keras.constraints import MaxNorm as maxnorm

import numpy as np

ipt = Input(batch_shape=(32,672,16))

x = LSTM(512, activation='relu', return_sequences=False,

recurrent_dropout=0.3,

kernel_constraint =maxnorm(0.5, axis=0),

recurrent_constraint=maxnorm(0.5, axis=0))(ipt)

out = Dense(1, activation='sigmoid')(x)

model = Model(ipt,out)

optimizer = Nadam(lr=4e-4, clipnorm=1)

model.compile(optimizer=optimizer,loss='binary_crossentropy')

for train_update,_ in enumerate(range(100)):

x = np.random.randn(32,672,16)

y = np.array([1]*5 + [0]*27)

np.random.shuffle(y)

loss = model.train_on_batch(x,y)

print(train_update+1,loss,np.sum(y))

观察:以下加速发散:

- 更高

units(LSTM) - 更高的层数(LSTM)

- 更高

lr<<时没有发散<=1e-4,测试了多达 400 列火车 - 更少

'1'的标签<<与下面没有分歧y,即使是lr=1e-3; 测试多达 400 辆列车

y = np.random.randint(0,2,32) # makes more '1' labels

更新:在 TF2 中未修复;from tensorflow.keras也可以使用进口来重现。